在发布智脑视觉大模型不到半个月后,三六零(601360)又在6月13日,发布其智脑大模型4.0版本,其特点是多模态、全端应用、数字人。

在发布会现场,三六零董事长周鸿祎认为,大模型至少有10年红利期;对个人和企业来说,数字人是未来人工智能大模型最合适的入口。

在周鸿祎看来,大模型的安全问题超越了内容安全,应该训练另一个GPT来监督GPT;未来如果只讲发展不讲安全,该大模型会走不远。据其透露,360已启动了安全团队在人工智能安全上的研究,首创了一个大模型安全风险的评估体系AISE,下一步将会公布。

(资料图片仅供参考)

(资料图片仅供参考)

6月13日上午,三六零股价大涨超9%,但午后逐渐回落,最终以5.49%的涨幅收盘,目前市值为1099亿。

已赶上国际平均水平

大模型至少有10年红利期

在发布会现场,与会者普遍感觉到,周鸿祎明显变瘦了。

对于国内大模型的发展水平,周鸿祎表示,“国内现在(AI大模型)你追我赶,不断相互激励,缩小和全球领先技术的距离。原来我说(差距)有一年半、两年,我今天收回这句话。我认为国内现在这种发展迭代速度,已经基本赶上或者接近国际平均水平。”

对于如何做大模型,周鸿祎认为,现在不应该只是拘泥于做很多通用的基础能力,而应该想一想,如何把大模型做成真正像电一样,能够输送到百行千业、千家万户、千千万万企业,输送到亿万个办公一族身边,这样才能产生工业级革命的力量。

“大模型就像发电场一样,通过训练大数据,直接产生了电力,可以把通用的人工智能能力直接输送给每个行业和企业,把石油加工成电,这就产生了未来5-10年新的工业革命的机会。”

在周鸿祎看来,今天大模型的价值,不仅仅在于ChatGPT的使用量,以及一些互联网场景的结合,更在于未来把大模型这种人工智能的能力垂直化、产业化、企业化、个人化,“这样的产业机会刚刚开始,未来至少有10年的红利期”。

据其介绍,谷歌发布的大模型策略中,有四种大小尺寸不一样的大模型。

Facebook发布的以“LLaMA羊驼”为首的开源大模型里面,有一种方式是把大模型越做越大,参数越大,训练的语料越大。

但还有一种方式,是把大模型做小,即把它用在垂直领域,让甚至可以安装在一台电脑或者手机上。如果能装在手机上,就意味着大模型将来可以部署在边缘技术设备,甚至部署在IoT设备上。

因此,在“做大”的同时,大模型还有一个“做小”的方向。

“应该自己抽自己几耳光”

在周鸿祎看来,大模型的难度已经不在于模型,模型有很多选择,算法基本上都是公开的。

“今天的挑战在于,用什么样的数据做预训练,用什么样的题海战术做有监督的微调。最后还有一个很重要的,就是这模型必须要在互联网上找到用户使用,因为用户的使用他想到了各种例子,远远超越我们自己内部的测试。”

因此,周鸿祎认为,今天训练大模型应该说不难,其壁垒在于数据、用户标注、答题的标注,以及用户的使用反馈。

谈到此处时,周鸿祎突然表示了深刻的反省:

“当然说起来也很惭愧,讲这一页的时候,我觉得我们做搜索的公司都应该自己抽自己几耳光。”

实际上,搜索公司都在发展大模型技术,无论是Bing、百度,还是谷歌。2018年,谷歌发布了BERT算法,360当时就进行了跟踪和使用,后来包括T5和GPT这几个版本,360也进行了研究和跟进。

我们确实缺乏OpenAI的这种精神,他们这些人对通用人工智能有一种执念,他们梦想把人类所有的知识训到一个大模型里面,而且坚定地走只有解码器的路线。

其他的公司虽然也都用大模型,我们就比较鸡贼地用大模型解决很多现实的问题,比如广告点击率高一点,推荐的内容好看一点,给你推荐的视频让你欲罢不能,大家都忙着做跟现实场景的结合。

用GPT监督GPT

人工智能是一把双刃剑,大模型本身也会有漏洞,会被人利用。

业内普遍认为,发展大模型的三大要素是算力、算法、数据,但周鸿祎认为应该改成算力、数据和训练,而且还应加上“安全”。

“不管在哪一个国家做大模型和生成式AI,都要保证输出的内容不能违背当地的法律法规,要符合当地的道德习俗。原来我认为这是Mission Impossible(不可能完成的任务),但在工程人员的研究下,我们找到了一个突破。怎么保证GPT不说错话?答案是训练另外一个GPT来监督这个GPT。”周鸿祎表示。

在周鸿祎看来,大模型的安全问题超越了内容安全,还有更多内涵。

“大模型可以让一个小白变成专家,也能让一个很低水平的、原来当不了黑客的人,变成能写攻击代码、钓鱼邮件、研究系统漏洞的坏家伙,使得干坏事的成本降低了很多。”

据其透露,360已经启动了安全团队在人工智能安全上的研究,首创了一个大模型安全风险的评估体系AISE,下一步将会公布。

而在6月10日的北京智源大会上,OpenAI联合创始人、CEO萨姆·奥特曼(Sam Altman)当时在演讲中表示,“AI安全是最新的技术,需要思考关键的AI安全问题,需要构建安全的分类器和检测器,以监测符合用户政策的情况,这一点很重要。”

萨姆·奥特曼当时称,应该推动并引导与安全研究一致的投资。他当时表示,正在投资几个新的且有望能取得成果的方向,其中之一是可扩展的监督,尝试使用AI系统来协助人类监督其他AI系统。

“未来如果只讲发展不讲安全,这个大模型是走不远的。我们把安全能力和大模型的研发结合起来,一方面用安全加强大模型的能力,另外一方面用安全使大模型更加可控。”周鸿祎强调。

对此,一位业内资深人士对记者表示,这个方向是对的,因为人工智能的能力一般人监管不过来,一定是以其人之道还治其人之身,训练一个能够监管人工智能的人工智能,或者用智能更高的人工智能监管智能水平低的人工智能,如用GPT5来监管GPT4。

大模型又迎发布潮

聚焦应用产品大规模升级上线

2023年4月,中国移动研究院发布了《我国人工智能大模型发展动态》。报告显示,国内大模型整体与GPT3.0性能相当,百度、腾讯、阿里、华为等处于第一梯队。

从大模型的布局体系来看,科技大厂在算力层、平台层、模型层、应用层进行了四位一体的全面布局。百度、阿里、华为三家均从芯片到应用进行自主研发的全面布局,如百度的“昆仑芯+飞桨平台+文心大模型+行业应用”、阿里的“含光800芯片+M6-OFA 底座+通义大模型+行业应用”、华为的“昇腾芯片+MindSpore 框架+盘古大模型+行业应用”。

从大模型参数量看,科技大厂的参数量远大于科研院所。

2023年5月,科技部直属的中国科技信息研究所在中关村论坛发布《中国人工智能大模型地图研究报告》。

据该报告不完全统计,截至目前,参数在10亿规模以上的大模型全国已发布了79个。其中,科技大厂的大模型参数量较大:阿里通义千问大模型参数在10万亿级以上、腾讯混元大模型和华为盘古大模型参数量均在万亿级以上、百度文心一言大模型参数量在2千亿级以上、京东言犀大模型的参数量为千亿级;垂直行业科技企业已经上线的参数量普遍在千亿级以上;而科研院校大模型的参数量在千亿级及以下。

民生证券研究院计算机团队认为,在经历二月至三月的大模型集中发布期、四月至五月的产品研发期和政策方向逐步明确后,六月起,人工智能大模型产品和应用有望迎来集中发布。

但是,不同于二三月份的纯粹大模型发布,新一轮发布潮,是基于大模型的应用产品开始大规模升级上线,为走进千家万户做准备。

从相关企业的情况来看,在科大讯飞、三六零之后,6月16日,华为人工智能框架生态峰会也将在上海召开,举办“上海昇思AI框架&大模型创新中心启动暨伙伴入驻仪式”,以共建AI开源生态。

(文章来源:中国基金报)

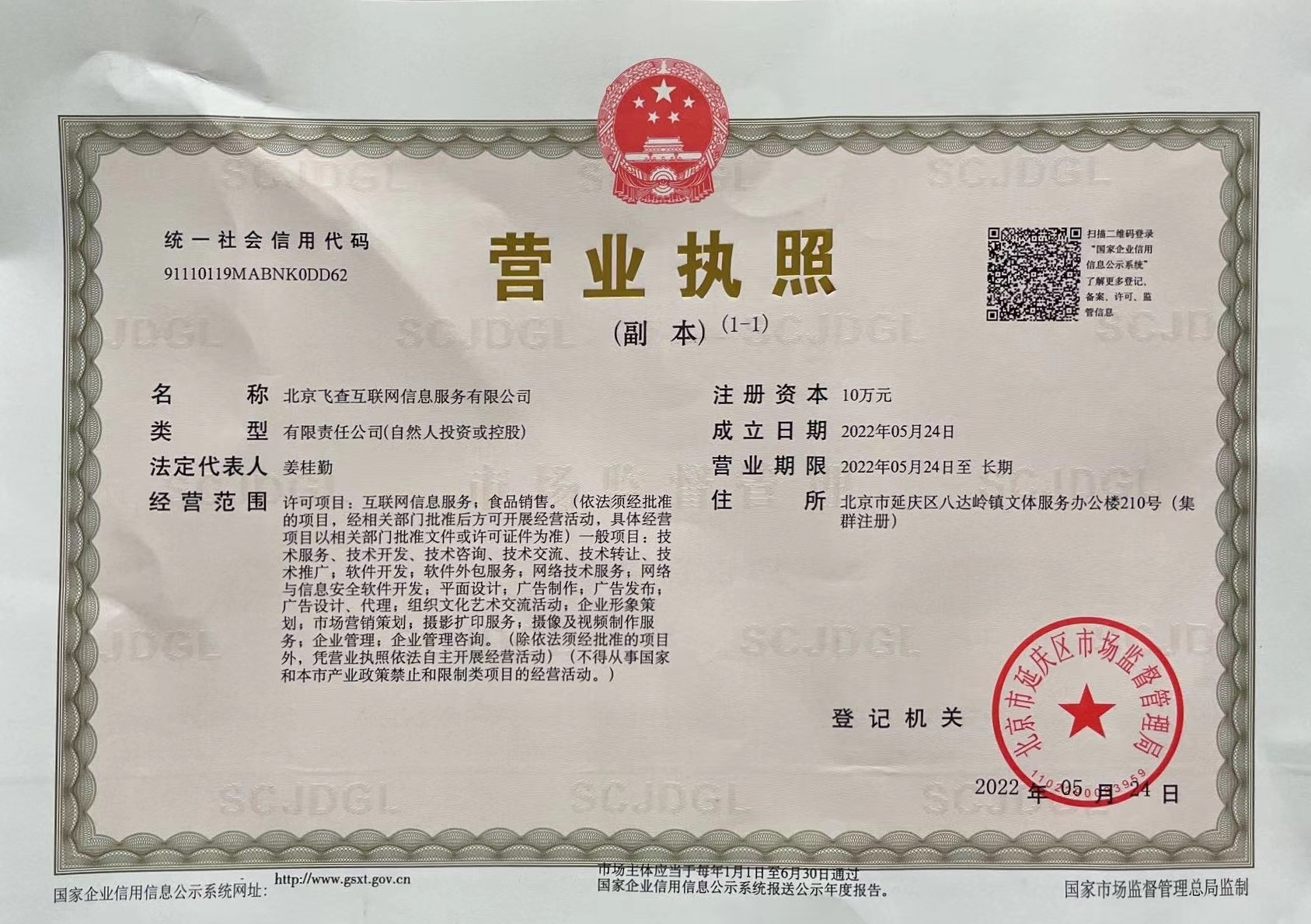

营业执照公示信息

营业执照公示信息